整体架构:

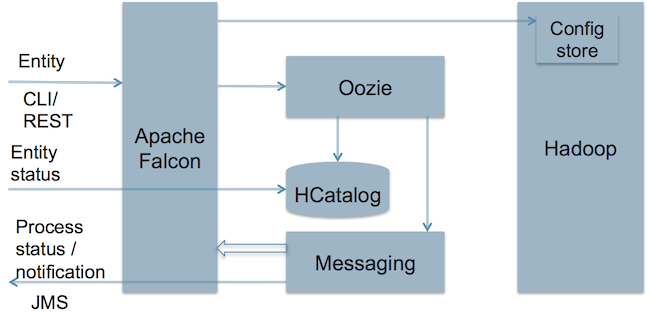

Apache Falcon 提供了一个用于治理和编排 Hadoop 内部和周边数据流的数据处理框架。该框架为获取和处理数据集、复制与保留数据集、重新定向位于非Hadoop扩展中的数据集、维护审核跟踪与沿袭提供了关键性的管控框架。Knox拓展了Hadoop的安全边界,实现了与LDAP、用于证书管理的活动目录等框架进行了充分整合,为跨Hadoop和所有相关项目的授权提供了一个通用服务。下面是Falcon的架构图:

从上图可以看出,Apache Falcon:

- 在Hadoop环境中各种数据和处理元素(processing element)之间建立了联系;

- 可以与Hive/HCatalog集成;

- 根据可用的Feed组向最终用户发送通知。

用途特性:

Apache Falcon可以满足企业数据管理的以下三方面需求:

| 需求 | 特性 |

|---|---|

| 集中化数据生命周期管理 |

|

| 合规与审计 |

|

| 数据库复制与存档 |

|

023-68661681

023-68661681

返回

返回

发表评论